Artificial Intelligence is geen science fiction meer. Helaas komt het ook met nieuwe privacygevaren

Kunstmatige intelligentie, of AI, is sinds eind november op grote schaal beschikbaar gesteld voor het publiek. Als gevolg hiervan zijn veel experts op hun hoede over misbruik ervan. Scholieren die huiswerk laten maken door ChatGPT, een chatbot met kunstmatige intelligentie, of mensen die worden ‘gekopieerd’ in video’s in de vorm van deepfakes. Experts waarschuwen ook dat er oplichters zijn die AI kunnen gaan gebruiken om hun oplichtingspraktijken gemakkelijk geloofwaardiger te maken. Je leest hier hoe.

Nieuws naar aanleiding van de lancering van AI-chatbot ChatGPT vliegt je om de oren. Klaslokalen, redacties en zelfs beurzen zoeken naar een plekje voor de chatbot binnen de onderneming zodat deze ‘mee kan denken’. Maar gezien de chatbot (nu nog) gratis en openbaar is, kan deze helaas ook geraadpleegd worden door criminelen. Hoewel er nog geen concreet voorbeeld heeft plaatsgevonden, kwamen onderzoekers al tot de conclusie dat het zeer zeker mogelijk is.

Phishingberichten op maat gemaakt

Online oplichting komt in allerlei soorten en maten; vaak in de vorm van tekst. Denk aan valse e-mails van je bank, nepadvertenties of vacatures die niet echt zijn. “Deze oplichting kun je doorgaans herkennen doordat veel van die geautomatiseerde berichten erg slecht zijn geschreven of webpagina’s die ongeloofwaardig waren”, zegt een cybersecurityexpert tegen Consumer Affairs.

Een hacker kan persoonlijke informatie gemakkelijk van je opzoeken en deze aan de chatbot geven. Hierdoor kan deze chatbot geheel zelfstandig een op maat gemaakt phishingbericht naar jou en duizenden anderen sturen, welke dan ineens een stuk geloofwaardiger zijn.

Spoofing in een nieuw jasje

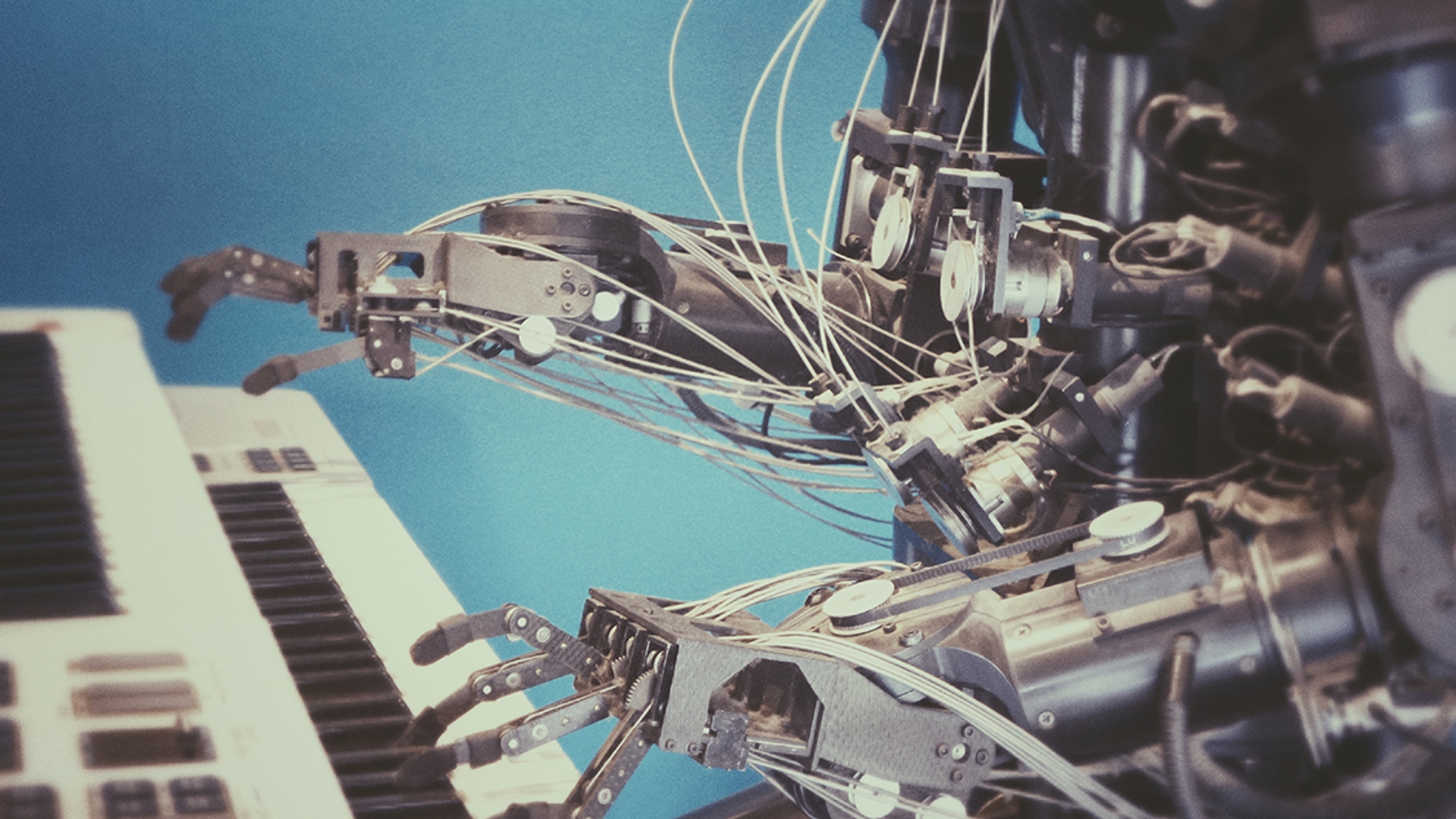

Niet alleen maakt AI zijn intrede op het gebied van tekst. Ook audio kan gemanipuleerd worden met bepaalde algoritmes. Zo is Microsoft bezig met haar eigen AI op het gebied van audio, genaamd VALL-E. Deze robot wordt ontworpen om stemmen te herkennen en te kunnen kopiëren. Wanneer je een opname van soms maar drie seconden (!) hebt van iemands stem, kan deze robot deze stem kopiëren.

De bekende scam is dat iemand wordt bericht dat zijn of haar kind geld nodig heeft. Wanneer deze mensen gebeld worden, en de stem van hun kind horen, kan het natuurlijk erg overtuigend zijn.

Veiligheidsmaatregelen

Het is natuurlijk niet alleen maar kommer en kwel. De gloednieuwe technologie komt met gevaren, maar veel mensen zijn bezig om consumenten zo goed mogelijk te beschermen tegen misbruik ervan. Bij OpenAI, de ontwikkelaar van ChatGPT, programmeren ze een aantal beveiligingen in de chatbot om misbruik moeilijker te maken. Wanneer er bijvoorbeeld wordt gevraagd of de bot een computervirus in programmeertaal kan uitschrijven, gaan er alarmbellen rinkelen.

Ook zijn er in Nederland verschillende AI-onderzoeklaboratoria opgericht, genaamd Innovation Center for Artificial Intelligence (ACAI). Deze laboratoria, die onder de paraplu van de UvA vallen, moeten structuur brengen in de huidige AI-chaos. “We willen dat kunstmatige intelligentie in alle vakgebieden transparant is, zodat kan worden nagegaan of er geen vooroordelen worden versterkt. We moeten garanties kunnen gegeven op feiten die naar boven komen. Bewijzen dat de inhoud nauwkeurig is, en dat veiligheid van data zowel op het gebied van privacy als bedrijfsgevoelige informatie gegarandeerd is”, vertelde Maarten de Rijke, hoogleraar Kunstmatige intelligentie aan de UVA en directeur van ACAI, tegen het Parool.

Bron: Consumer Affairs/ACAI/Parool

Praat mee

Altijd op de hoogte blijven van het laatste nieuws?

Meld je snel en gratis aan voor de Kassa nieuwsbrief!